Trend

인공지능 기반 영화 제작 2.0 시대를 향해

- 글

- 정찬철(국립부경대학교 미디어커뮤니케이션학부 교수)

Trend

오늘날 소라(SORA), 에뮤 비디오(Emu Video), 미드저니(Midjourney), 달리(DALL-E) 등과 같은 거대 언어 모델(LLM) 기반 이미지 및 동영상 생성 인공지능(AI) 프로그램의 등장으로 영화 제작 환경은 버전업되고 있다. 2021년에 필자는 『한국영화』에 기고한 인공지능 기반 영화 제작 기술에 관한 글에서 딥페이크나 인공지능 기반의 로토스코핑(Rotoscoping) 프로그램 알파갠(AlphaGAN)과 영화 흥행 예측 프로그램 시네리틱(Cinelytic) 등의 잠재적 가치를 다루었다.1) 이와 같은 인공지능 영화 제작 기술을 1.0세대라 부른다면, 여기서 다룰 거대 언어 모델 기반 인공지능 영화 제작 기술은 2.0세대로 구분해 부를 수 있다. 이전과 달리 2.0세대의 인공지능 영화 제작 기술은 단순히 기존의 수공적인 시각효과 작업을 자동화하거나, 정교화하거나, 효율화한 것에 머물지 않고, ‘언어 모델 기반 인공지능’이라는 표현에서 알 수 있듯이 인간과 문자로 소통하며 작동할 수 있는 수준으로 진보해 왔고, 그렇게 발전해 갈 것이기 때문이다. 이와 같은 거대 언어 모델 기반 인공지능 영화 제작 기술은 디지털 시각효과의 중요 부분이자 수작업 집약형 영역인 로토스코핑, 3차원(3D) 애니메이션, 동영상 생성, 3D·2D 환경 이미지, 버추얼 휴먼(아바타) 생성, 더빙 등에 적용돼 작업의 효율 및 정확도와 시각효과의 완성도를 높이는 데 기여하고 있다. S&P 글로벌 마켓 인텔리전스(S&P Global Market Intelligence) 2023년 보고서에 따르면 이와 같은 생성적 인공지능 기술 시장은 2023년 약 37억 달러(한화 약 5조 98억 원)에서 2028년 약 363억 달러(한화 약 49조 1502억 원)까지 대략 10배 성장할 것으로 예측된다.

1)정찬철, 「인공지능은 영화의 미래다」,『한국영화』, 2021년 127호, 22-27쪽. 정찬철, 「 마인드 유니버스가 쏘아올린 창조의 기술, 딥페이크」,『한국영화』, 2021년 137호, 24-29쪽.

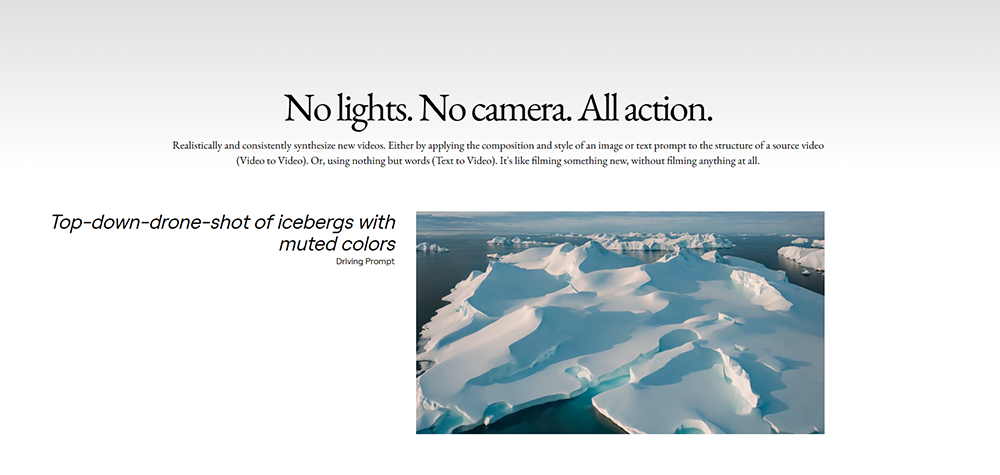

대표적인 사례는 런어웨이(Runaway, https://research.runwayml.com)에서 개발한 ‘Gen-1’, 프롬프트(Prompt, 텍스트로 된 설명문) 기반 ‘텍스트 to 비디오(Text-to-Video)’ 동영상 생성 및 합성 등의 생성형 인공지능 시각효과 기술이다. [그림1]에서와 같이 ‘top-down-drone-shot of icebergs with muted colors’라는 프롬프트를 입력하면 Gen-1은 그것에 어울리는 동영상을 생성한다. 뿐만 아니라 Gen-1은 기존에 촬영한 영상이나 이미 생성한 영상을 서로 합성하거나 원하지 않는 대상만을 제거하고, 동영상을 확장하는 등의 기술을 제공한다. Gen-1이 매우 사실적인 영상을 생성하고, 이음새 없이 영상을 합성할 수 있는 것은 스테이블 디퓨전(Stable Diffusion)이라는 영상의 노이즈를 제거하는 방식의 생성형 인공지능 기술을 사용하기 때문이다. 오픈AI(OpenAI)에서 개발한 ‘소라’와 메타(META)의 ‘에뮤 비디오’ 모두 같은 방식의 인공지능 영상 생성 프로그램이다. 이와 같은 인공지능 기반 영상 생성 기술은 다양한 영상 속 배경 이미지를 저렴한 비용으로 창조해 낼 수 있기에 가상 제작(Virtual Production)의 배경 이미지 및 저예산 영화들에 활용될 수 있다는 잠재력이 높다. 2023년 아카데미 시상식에서 작품상, 감독상, 남녀조연상, 편집상 등 7관왕을 휩쓴 <에브리씽 에브리웨어 올 앳 원스>(Everthing Everywhere All at Once)는 사실 인공지능 기술로 완성된 영화이기도 하다. 다양한 유니버스를 넘나드는 이 영화의 사실적이고, 환상적 공간, 그리고 화려한 액션 등에 디지털 시각효과가 사용됐는데, 총 6명의 시각효과 아티스트가 참여했다는 점이 세간의 화제가 됐다. 소규모의 시각효과팀이 대규모의 시각효과 작업을 수행할 수 있었던 것은 런어웨이의 Gen-1을 활용한 결과였다. 그린스크린 영상의 합성, 로토스코핑, 합성, 그리고 포스터 제작 등에 Gen-1이 사용됐다. <에브리씽 에브리웨어 올 앳 원스>는 인공지능 영화 제작 기술이 얼마나 효율적이고 경제적인가를 입증한 작품이기도 하지만, 그것이 영화제작자에게 실사 촬영과 시각효과를 얼마나 사실적이고, 환상적으로 합성하고, 수공적 방식으로는 구현하기 어려운 복잡한 장면의 연출을 창조할 수 있도록 도울 수 있다는 것, 즉 인공지능과 인간의 창조적 협업의 가능성을 입증한 작품이기도 하다.

인공지능 기반 모션 캡처 2.0생성형 인공지능 분야 중에서 가장 효과적으로 활용될 수 있는 분야가 모션 캡처다. 그동안 가장 고비용, 비효율 분야 중 하나였기 때문이다. 모션 캡처의 경우 배우의 얼굴이나 몸의 동작을 애니메이션 데이터로 변환해 컴퓨터그래픽(CG) 캐릭터를 자연스럽게 움직이는 기술로, 지금까지는 실제 배우가 모션 캡처 장비를 착용하고 연기하는 방식으로 진행되었다. 잘 알려져 있다시피, <킹콩>(2005)<아바타 1, 2>(2009~2022)<승리호>(2021)에 등장하는 사실 같은 3D 캐릭터는 모두 모션 캡처 기술로 제작됐다.

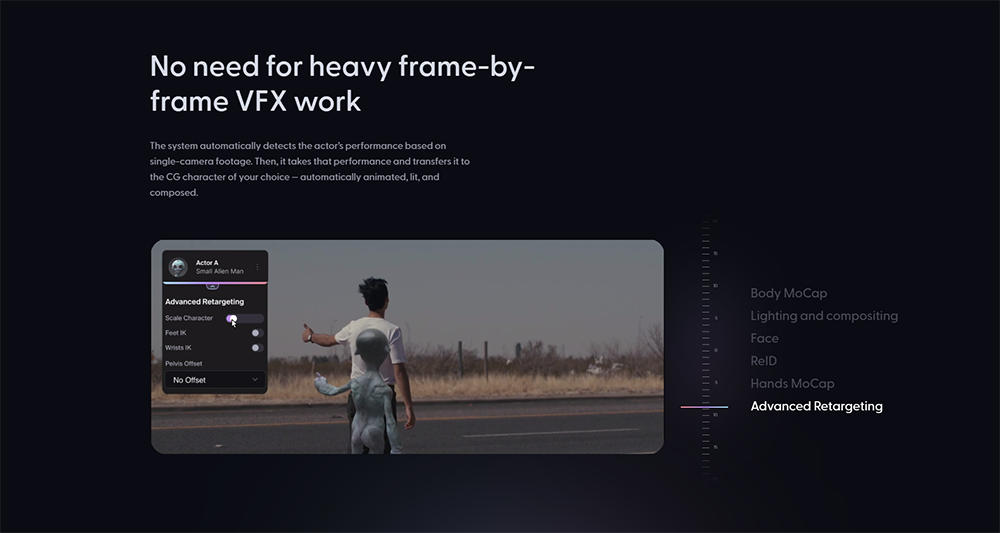

하지만 앞서 언급한 바와 같이 모션 캡처 과정에서 발생하는 데이터 오류가 많아 이를 수공적으로 수정하는 작업 등 후처리에 많은 인력이 투입돼야 하는 단점이 있다. 인공지능 기반 영화 제작 기술의 초창기 시기에는 이러한 오류를 보정하는 데 활용이 됐다. 예를 들어, <어벤져스: 인피니트 워>(Avengers: Infinity War, 2018)에서 타노스(Thanos) 캐릭터를 보다 사실적이고 있을 법한 존재로 만들기 위해 디지털 도메인은 페이셜(Facial) 캡처를 통해 얻은 표정 정보의 오류를 수정하고 보강했는데, 이를 위해 마스쿼레이드(Masquerade)라는 인공지능 기반 모션 캡처 기술을 개발했다. 이것을 인공지능 기반 모션 캡처 1.0 기술로 분류하자면, 최근에는 생성형 인공지능 기술을 이용해 모션 캡처 장비를 착용하지 않아도, 영상에 있는 배우의 움직임을 추적해 자동으로 원하는 3D 캐릭터로 전환해 주는 2.0세대의 기술이 등장하고 있다. 즉, 모션 캡처 과정을 처음부터 최종 단계까지 완전히 인공지능 기술로 대체한 것이다. 대표적인 회사는 원더 다이내믹스(Wonder Dynamics)다. 이 회사에서는 모션 캡처에 필요한 페이셜 캡처, 보디 캡처, 라이팅 및 합성 등의 모든 공정을 완전히 자동화한 인공지능 기반 모션 캡처 프로그램을 제공한다. 기존의 모션 캡처 제작 방식은 배우의 얼굴에 도트를 붙이거나 특정한 모션 캡처 슈트를 착용해야 하는 등 배우의 입장에서는 연기에 있어 많은 제약을 초래하는 방식이었다. 인공지능 기반 모션 캡처 기술은 이러한 모든 부가적인 요소 없이도 저비용으로 동일한 결과를 낳을 수 있기 때문에, 그동안 블록버스터 영화의 제작에 주로 활용되었던 모션 캡처 기술이 보다 보편화되고, 영화 창작가의 상상적 캐릭터들이 보다 다양하고 환상적으로 영화 세계에 등장할 수 있을 것이라 예측한다.

최근 개발되는 인공지능 기반 더빙 기술은 영화의 본래 언어를 인공지능 기술을 통해 다른 언어로 번역한 후 동영상에 번역된 음성을 입히는 기술이다. 하지만 단순히 음성만 교체하는 것이 아니다. 기존 더빙 기술의 가장 큰 한계로 지적된 입술 움직임을 일치시키는 립싱크(Lip Syncing) 작업도 자동화했다는 점에서 향후 활용의 가치가 매우 높은 인공지능 기반 영화 제작 기술이라 볼 수 있다. 이 분야의 대표적 회사로는 플로리스(Flawless)와 몬스터 에일리언 로봇 좀비(Monsters Aliens Robots Zombies, MARS)가 있다. 아직은 기술 개발 단계이지만, 거대 언어 기반의 생성적 인공지능 기술이 영화 제작 공정 중에서 가장 효과적으로 활용될 수 있는 분야는 가상 제작이다. 무아레(Moire)의 제거, 사전시각화(Pre-Vis), 모션 캡처, 3D 애셋 및 환경 애셋 제작 등 가상 제작의 주요 공정을 효율화 및 자동화할 수 있기 때문이다. 특히 LED 벽면에 사용할 3D 환경 애셋을 제작하고 이미 제작된 소스를 보강하는 데 동영상 생성 인공지능 기술이 미칠 잠재력은 매우 크다. 또한 가상 제작 파이프라인을 최적화하는 데 인공지능 기술이 활용될 수 있다. 대표적으로 글로벌 가상 제작 솔루션 스튜디오인 뷰 스튜디오(Vū Studio)는 자사의 가상 제작 전체 파이프라인을 최적화하는 데 인공지능 기술을 활용한다.

인공지능 영화 제작 3.0 시대?지금까지 살펴본 인공지능 기반 영화 제작 기술은 영화 제작의 공정을 부분적으로 인공지능 기술로 대체한 사례였다. 하지만 최근 앞서 언급했던 거대 언어 모델 기반의 동영상 및 이미지 생성 인공지능 기술의 등장으로, 소위 인공지능 영화(AI Cinema), 즉 시나리오, 촬영, 편집 등의 모든 과정에 인공지능 기술을 적용해 완성한 영화가 등장하고 있다. <선스프링>(Sunspring, 2023)은 벤저민(Benjamin)이라는 시나리오 생성 인공지능 프로그램을 활용했고, <피엘에스티씨>(PLSTC, 2023)는 영상 제작에 미드저니를 활용했다. <익스팬디드 차일드후드>(Expanded Childhood, 2023)는 사진의 경계를 확장하는 데 달리2(DALL-E 2)를 활용했다. <더 프로스트>(The Frost, 2023) 제작에서는 시나리오와 영상을 모두 인공지능이 담당했다. 페이블 스튜디오(Fable Studio)에서는 인공지능 기술을 시나리오, 애니메이션, 연출, 더빙, 편집 등 모든 단계에 적용해 <사우스 파크>(South Park) 에피소드로 <시뮬레이션>(Simulation)을 시험적으로 제작했다. 이 작품은 인공지능이 영화 제작의 모든 공정에 참여한 세계 최초의 애니메이션이 됐다. 이처럼 영화 제작의 공정을 부분적으로 대체했던 인공지능 기술은 점점 영화 제작 전체를 통합하는 단계로 나아가고 있다. 아마 이것은 인간의 역할을 인공지능 기술로 대체하고자 하는 이 인공지능 기술에 투영된 인간과 기술의 욕망일 것이다. 혹자는 이러한 생성형 인공지능 기술은 실사를 촬영하는 방식이 아닌 이미지를 생성하는 방식이기에 실사 영화 제작을 완전히 대체할 수 있는 기술로 발전하지 못할 것이라 주장할 수도 있다. 하지만 이렇게 학습된 인공지능에 우리가 사용하는 촬영 장비를 건넨다면 불가능한 일은 아닐지도 모른다. 그러한 능력을 겸비한 인공지능에 영화용 카메라와 편집 장비를 건네주면 인간의 연출력을 초월한 영화가 탄생할 수도 있을 것이다. 문제는 인공지능이 무엇을 담당할 것이냐가 아니라, 이렇게 발전하는 인공지능 영화 제작 기술의 현재와 미래에서 우리 인간의 역할을 규정하는 것이 아닐까 생각한다.

함께 읽으면 좋은 콘텐츠